Apple iCloud üzerinden çocuk istismarını tespit edip, bildirecek!

Apple, çocuklara yönelik cinsel istismar ve müstehcenliğe karşı çok konuşulacak yeni teknolojilerini duyurdu. iPhone, iPad ve Mac kullanıcılarının iCloud'ta depoladığı fotoğraflar üzerinden çocukların istismarının önüne geçmeye odaklanan ABD'li şirket, iCloud'taki müstehcen çocuk fotoğraflarını tespit edecek ve durumu raporlayıp, kolluk kuvvetlerine bildirecek.

Apple, çocukların güvenliği konusunda bir dizi yeni önlemi devreye almaya hazırlanıyor. Çocukların cinsel istismarının ve bunun online olarak yayılmasının önüne geçilmesi için attığı yeni adımları duyuran Apple, artık bundan sonra müstehcen çocuk fotoğraflarını tespit edip, bu kullanıcıları yetkili birimlere bildirecek.

Çocuklar için genişletilmiş koruma önlemlerini açıklayan ABD’li şirket, attığı adımları şu ifadelerle duyurdu:

“Çocukların cinsel istismar malzemesi (CSAM) yapılmasını ve bunun online olarak yayılmasını sınırlamak istiyoruz. Bunun için çocuk güvenliği uzmanlarıyla işbirliği içinde geliştirilen 3 alanda yeni çocuk güvenliği özellikleri sunuyoruz. İlk olarak, yeni iletişim araçları, ebeveynlerin çocuklarının çevrimiçi iletişimde gezinmelerine yardımcı olma konusunda daha bilinçli bir rol oynamasını sağlayacak. Bu kapsamda mesajlar uygulaması, özel iletişimleri Apple tarafından okunamaz halde tutarken, hassas içerik hakkında uyarmak için cihazdaki makine öğrenimini kullanacak. iOS ve iPadOS, CSAM'in çevrimiçi yayılmasını sınırlamaya yardımcı olmak için yeni şifreleme uygulamalarını kullanacak. CSAM algılaması, Apple'ın iCloud Fotoğrafları'ndaki CSAM koleksiyonları hakkında kolluk kuvvetlerine bilgiler sağlamasına yardımcı olacak.”

iOS 15 İLE DEVREYE ALINACAK

Bu yıl çıkacak iOS 15, iPadOS 15, watchOS 8 ve macOS Monterey güncellemeleriyle birlikte sunulmaya başlanacak olan Apple’ın bir diğer yeni çocuk güvenliği özelliği ile ise “Siri” ve “Arama” güncellemeleri, ebeveynlere ve çocuklara genişletilmiş bilgi sağlayacak ve güvenli olmayan durumlarla karşılaştıklarında yardımcı olacak. Siri ve Arama, kullanıcılar çocukların cinsel istismarıyla (CSAM) ile ilgili konuları aramaya çalışıldığında da müdahale edecek.

Apple’ın çocukların güvenliği için aldığı yeni önlemlerin detayları ise şöyle:

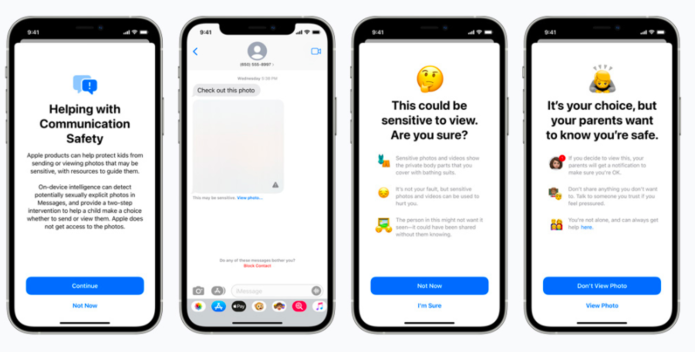

1- Mesajlarda müstehcen fotoğraflara bulanıklaştırma

Mesajlar uygulaması, müstehcen fotoğraflar alırken veya gönderirken çocukları ve ebeveynlerini uyarmak için yeni araçlar ekleyecek. Bu tür içerikler alındığında, fotoğraf bulanıklaştırılacak ve çocuk uyarılacak, yardımcı kaynaklar sunulacak ve bu fotoğrafı görmek istemezse, sorun olmayacağına dair güvence verilecektir. Ek bir önlem olarak, çocuğa, güvende olduklarından emin olmak için, görürlerse ebeveynlerinin bir mesaj alacağı da iletilebilecek.

Bir çocuk müstehcen fotoğraflar göndermeye çalışırsa benzer korumalar mevcut olacak. Çocuk, fotoğraf gönderilmeden önce uyarılacak ve çocuk göndermeyi seçerse ebeveynlerine bir mesaj iletilecek. Mesajlar, resim eklerini analiz etmek ve bir fotoğrafın müstehcen olup olmadığını belirlemek için cihazdaki makine öğrenimini kullanacak. Bu özellik, iOS 15, iPadOS 15 ve macOS Monterey için iCloud'da aile olarak ayarlanan hesaplara, 2021 yılı içinde bir güncelleme ile gelecek.

2- iCloud’taki fotoğraf üzerinden cinsel istismarı algılama

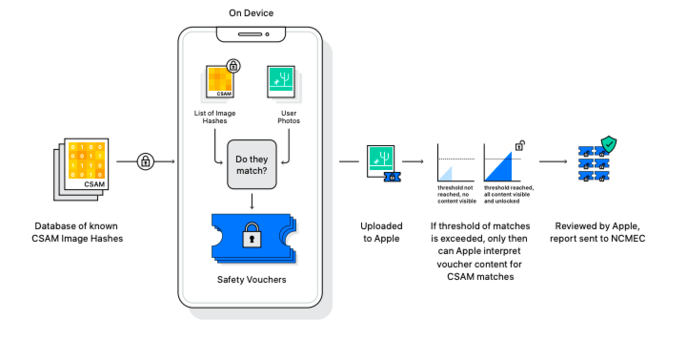

Çocuklara yönelik cinsel istismar ve müstehcenlik sorunu gidermeye yardımcı olmak için iOS ve iPadOS'ta devreye alınacak yeni teknoloji, Apple'ın iCloud Fotoğrafları'nda depolanan ve cinsel istismara yönelik görüntüleri algılamasına olanak tanıyacak. Bu teknoloji ile Apple, yaşanan durumları Ulusal Kayıp ve İstismara Uğrayan Çocuklar Merkezi'ne (NCMEC) bildirecek. Kapsamlı bir raporlama merkezi olarak hareket edecek olan NCMEC, ABD'deki kolluk kuvvetleriyle işbirliği içinde çalışacak.

.pngApple'ın cinsel istismarı algılama yöntemi sistemi, buluttaki görüntüleri taramak yerine, NCMEC ve diğer çocuk güvenliği kuruluşları tarafından sağlanan bilinen CSAM görüntü karmalarının bir veritabanını kullanarak cihaz üzerinde eşleştirme ile gerçekleşecek. Bir görüntü iCloud Fotoğrafları'nda saklanmadan önce, o görüntü için bilinen CSAM karmalarına karşı bir cihaz üzerinde eşleştirme işlemi gerçekleştirilecek. Eşleştirme işlemlerinin sonucuna göre kullanıcının hesabını devre dışı bırakılabilecek ve NCMEC'e konuyla ilgili bir rapor gönderilecek. Bu yeni teknoloji, Apple'ın NCMEC'e ve kolluk kuvvetlerine eyleme geçirilebilir bilgiler sağlamasına olanak tanıyacak.

3- Siri ve Arama'da genişleyen rehberlik

Apple ayrıca çocukların ve ebeveynlerin çevrimiçi ortamda güvende kalmasına ve güvenli olmayan durumlarla ilgili yardım almasına yardımcı olacak ek kaynaklar sağlayarak Siri ve Arama'daki rehberliği genişletiyor. Örneğin, Siri'ye CSAM'i veya çocuk istismarını nasıl bildirebileceklerini soran kullanıcılar, nerede ve nasıl rapor verecekleri konusunda kaynaklara yönlendirilecek.

Siri ve Arama da, kullanıcılar çocukların cinsel istismarı (CSAM) ile ilgili sorgular için arama yaptığında müdahale edecek şekilde güncellenecek. Bu müdahaleler, kullanıcılara bu konuyla ilgilenmenin zararlı ve sorunlu olduğunu açıklayacak ve bu sorunla ilgili yardım almak için kaynaklar sağlayacak. Siri ve Arama'ya yönelik bu güncellemeler, bu yıl iOS 15, iPadOS 15, watchOS 8 ve macOS Monterey'e yapılacak bir güncellemeyle gelecek.